2024. 1. 30. 18:20ㆍSKKU DT

아래 링크의 가이드를 따라서 Stable Diffusion을 설치한다.

stable-diffusion 설치법 및 사용법, 간단하게 원클릭 설치!

그림Ai 툴에 대해 궁금하신가요? 최근에 웹이나 앱으로 그림을 만들어주는 사이트가 많이 생겼는데요 하지만 제약사항도 많고, 일정 수 이상 사용하거나, 필터링이 걸려 그림을 그려주지 않거나

alltommysworks.com

압축파일 받고 update.bat 실행, run.bat 실행하면 아래의 창이 뜬다. 시간이 꽤나 많이 걸린다.

설치가 잘 되었다면 페이지가 하나 열린다.

Diffusion 방식은 노이즈에서 시작하여 점점 또렷하게 보여지게 하는 방식이다.

프롬프트 참고 사이트

Civitai: The Home of Open-Source Generative AI

Explore thousands of high-quality Stable Diffusion models, share your AI-generated art, and engage with a vibrant community of creators

civitai.com

스테이블 디퓨전 프롬프트 공유 사이트 prompts.co.kr

스테이블 디퓨전 프롬프트 공유 사이트. stable diffusion prompt share user community for Korean. share your prompt.

prompts.co.kr

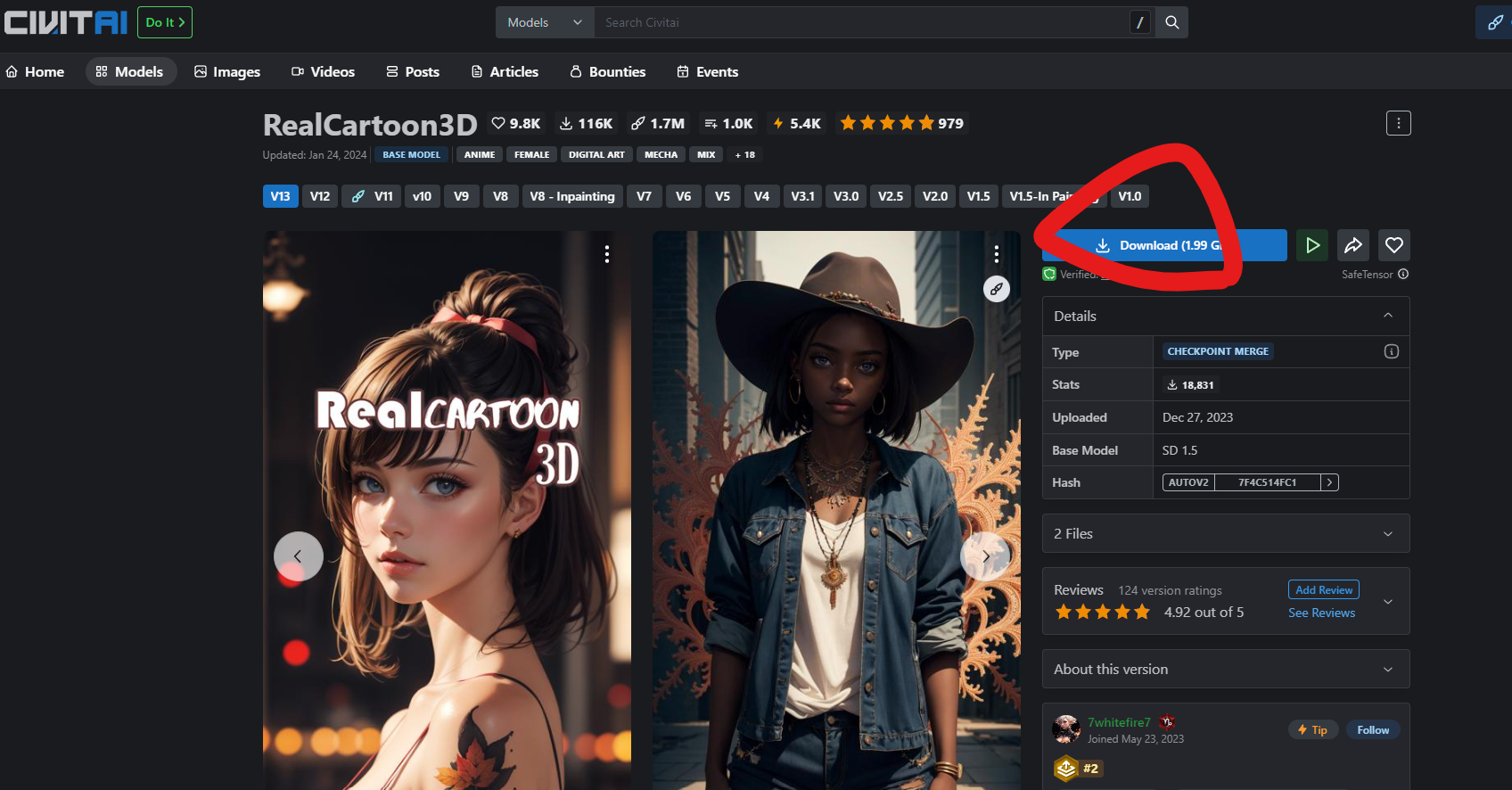

civitai.com 사이트에서, 모델을 다운받으면 훨씬 퀄리티 좋은 결과물을 볼 수 있다.

상단의 Models 탭에 들어가서 Checkpoint라고 쓰여있는 모델들로부터 모델을 다운로드 받는다.

다운 받아진 모델을 Stable Diffusion이 설치된 아래의 경로로 넣는다.

(C:\Users\User\Documents\sd.webui\webui\models\Stable-diffusion)

이전의 결과물과는 비교할 수 없을 정도로 좋은 퀄리티의 그림이 나왔다.

같은 프롬프트에 다른 모델만 적용했다면 결과물이 어떻게 다를까

완전히 같은 프롬프트와 값을 주었고 모델만 바뀌었다. 배경 분위기는 거의 비슷하고 캐릭터에 대한 실사화 느낌이 달라졌다.

캐릭터에게 행동 부여하기

https://github.com/mikubill/sd-webui-controlnet

위의 링크를 Stable Diffusion의 Extentions에 붙여넣는다.

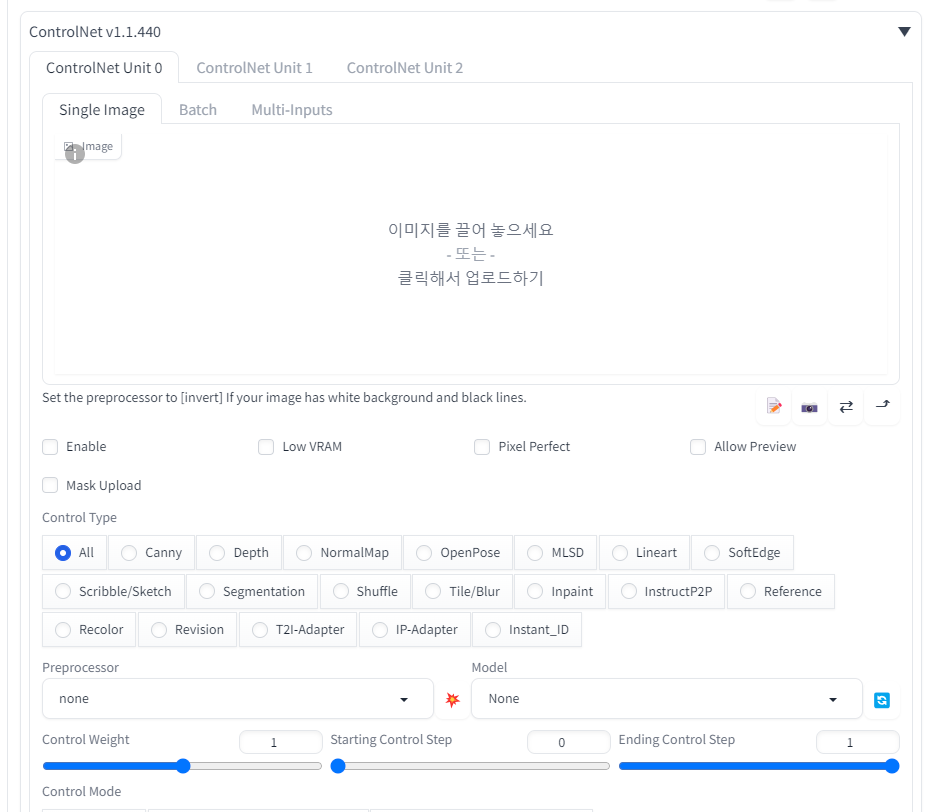

설치가 잘 된 것을 볼 수 있다.

설치가 되었다면 다시 시작해서 옵션을 볼 수 있다.

OpenPose를 받기 위해서 아래의 링크로 접속한다.

https://huggingface.co/lllyasviel/ControlNet/tree/main/models

lllyasviel/ControlNet at main

Detected Pickle imports (4) "torch._utils._rebuild_tensor_v2", "torch.LongStorage", "collections.OrderedDict", "torch.FloatStorage" What is a pickle import?

huggingface.co

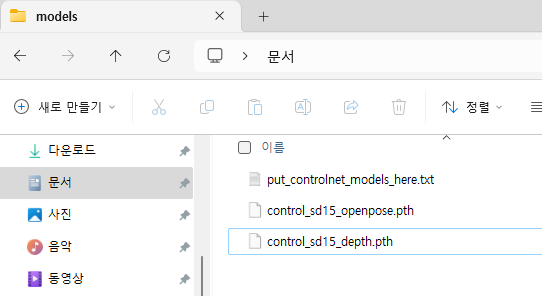

아래의 폴더 경로에다가 .pth 파일을 넣는다.

C:\Users\User\Documents\sd.webui\webui\extensions\sd-webui-controlnet\models

잘 인식 되었다면 Depth를 눌렀을 때 control_sd15_depth 모델이 뜬다.

[OpenPose]를 선택한 후 캐릭터가 했으면 하는 자세의 이미지를 끌어다 놓고 생성하면 이미지대로 자세를 취한 결과물이 나온다.

일반 사진은 [dw_openpose_full]을 쓰고 스틱맨 형태이면 [none]을 선택한다.

LoRA

LoRa도 다운로드 받아서 아래의 경로에 넣은 후

C:\Users\User\Documents\sd.webui\webui\models\Lora

Stable Diffusion 페이지로 가서 Lora 탭에서 Refresh를 한 후 다운 받았던 모델을 눌러 적용하면 된다. 그러면 프롬프트 아래에 lora에 대한 프롬프트가 생성된다.

img2img

img2img

색만 다른 옷을 입게 하고 싶을 때 사용한다. 하지만 랜덤성이 강해서 잘 쓸 수는 없다.

inpaint

특정 부분만 바꾸고 싶을 때 사용한다.

img2img에서도 포즈 데이터를 적용할 수 있다.

원래 앉아있던 이미지를 서있는 사람으로 바꾸려고 하니 바꿔졌다.

아래의 magicposer 사이트에서 내가 원하는 포즈로 캐릭터를 움직인 후 해당 이미지를 넣으면 원하는 포즈를 쉽게 이미지에 적용할 수 있다.

https://webapp.magicposer.com/

Magic Poser Web

webapp.magicposer.com

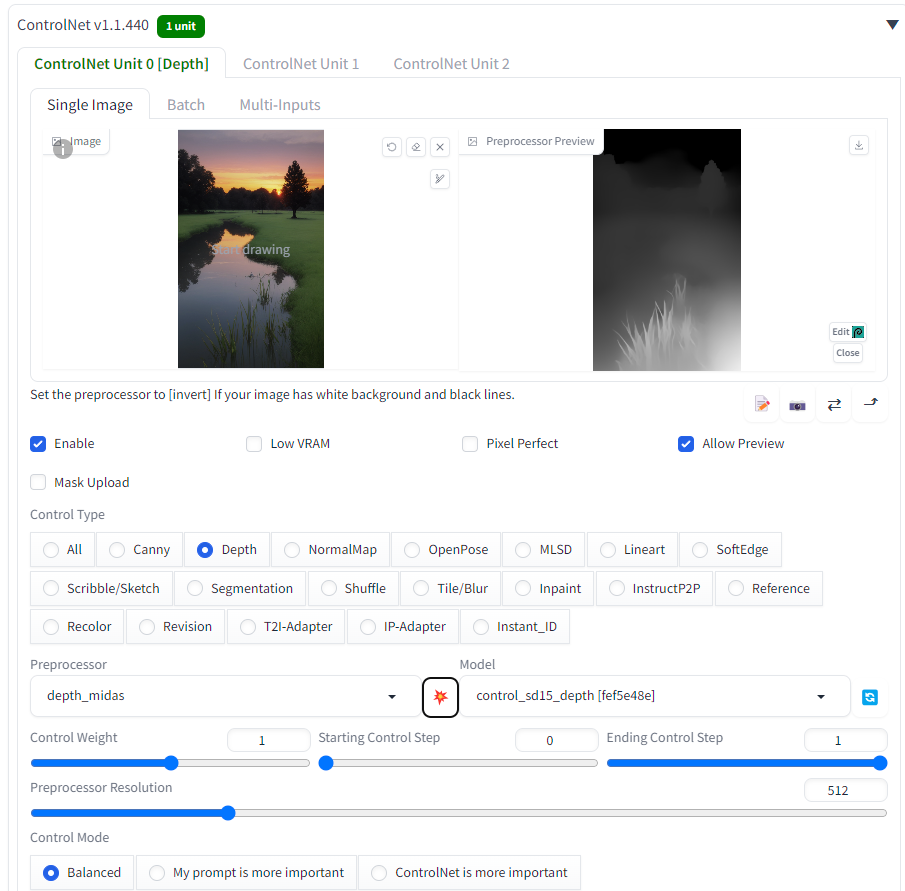

Depth

depth로 설정하고 이미지를 만들면, 배경 이미지의 경우 깊이값을 만들어준다. 하얀색일 수록 가깝고, 검은색일 수록 먼 하나의 라이트맵이 만들어지는 것이다.

Preprocessor와 Model 옵션 사이의 폭탄 모양을 누르면 프리뷰 이미지를 볼 수 있다.

depth 이미지를 다운로드 받고 img2img로 가서 다시 depth 옵션을 켜고 프롬프트를 돌리면, 같은 구도로 다른 이미지가 생성된다.

그냥 txt2img에서도 가능하다.

처음에 나뭇잎들이 있던 자리가 하늘로 바뀐 것이 인상적이다.

depth의 여러 선택지 중 괜찮은 옵션을 선택할 수 있다.

zoe를 선택하니 더 선명해졌다. 확실히 이전보다 만들어진 이미지의 depth가 비슷해지긴 했다.

프롬프트 자동 완성

아래의 extension을 설치하면 프롬프트에서 자동완성되는 것을 볼 수 있다.

https://github.com/DominikDoom/a1111-sd-webui-tagcomplete

ControlNet 기능들

'SKKU DT' 카테고리의 다른 글

| [SKKU DT] 66일차 -유니티 UI 활용하기 (0) | 2024.02.02 |

|---|---|

| [SKKU DT] 65일차 -유니티에서 ChatGPT Api 가져오기 (0) | 2024.02.01 |

| [SKKU DT] 62일차 -AI 알아보기, 기업 특강, 챗봇 생성하기, 블렌더 스크립트 생성 (0) | 2024.01.29 |

| [SKKU DT] 61일차 -Azure Digital Twin 실습(3), Postman (0) | 2024.01.26 |

| [SKKU DT] 60일차 -Azure Digital Twin 실습(2) (0) | 2024.01.25 |